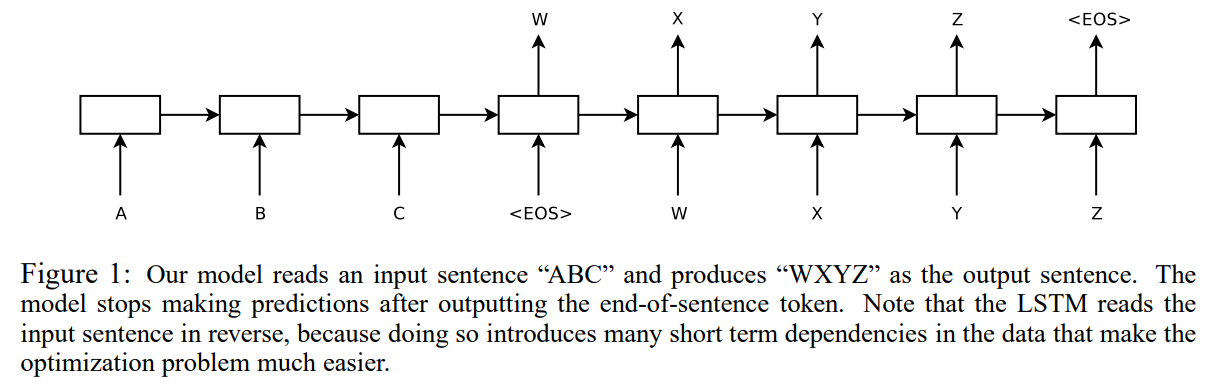

2014년 NIPS에 발표된 Sequence to Sequence Learning with Neural Networks 논문 리뷰 포스팅입니다. 이 논문은 LSTM을 활용한 Seq2Seq 기계 번역 아키텍처를 제안하는 NLP 분야의 기초 논문입니다. 이전의 DNN을 통한 Translation 은 SMT, 즉 통계적 방식을 통한 번역의 부분적 요소로만 활용되었습니다. 언어의 특성 상 요소들의 관계나, 연속적인 데이터를 통해 출력을 내놓는 것이 쉽지 않았기 때문입니다. 이 후 RNN 이나 LSTM 처럼 Sequence data에 대해서도 좋은 성능을 보여주는 모델이 등장하게 됩니다. 그러나 이들의 문제점은 Input 으로 Fixed-length vector를 넘겨주어야 한다는 점인데, 가변적인 길이를 가지는..