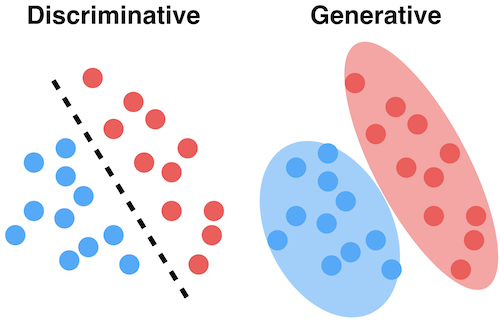

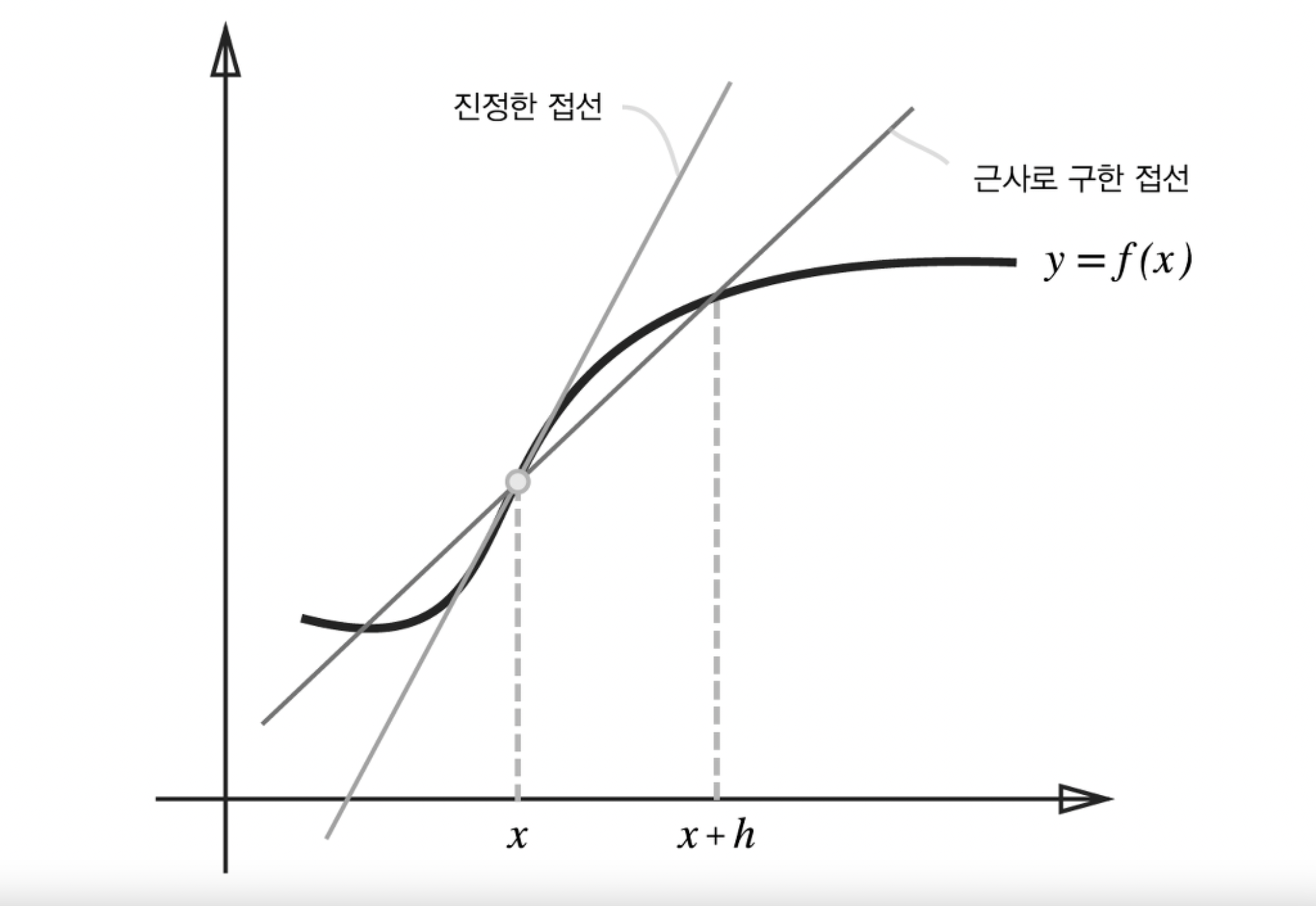

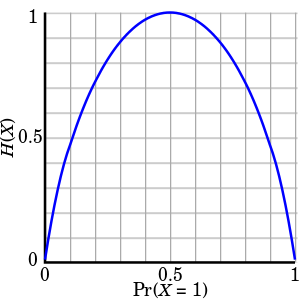

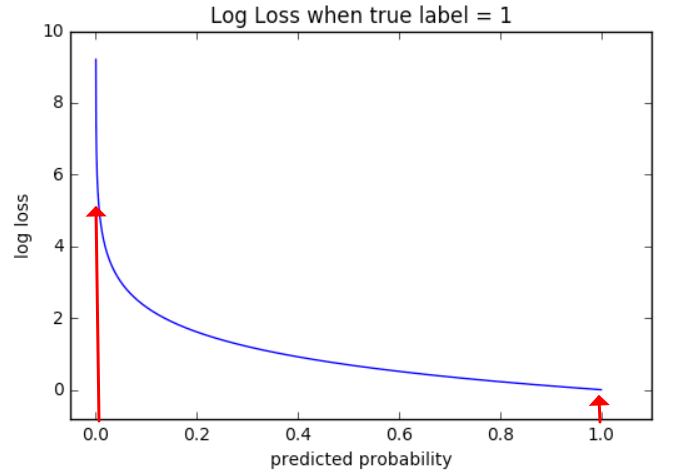

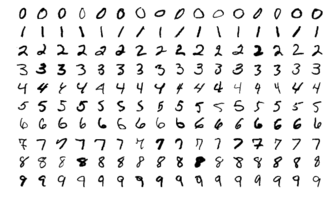

이번 포스팅에서는 Generative / Discriminative model이 무엇이고, 이 둘의 차이점에 대해 다룹니다. 머신러닝 모델은 크게 2가지 타입, Generative model과 Discriminative model로 분류될 수 있습니다. 우리는 이미 이런 모델들을 사용해 이미지를 생성하기도 하고, 자연어를 처리하기도 하고, 객체 탐지나 세그멘테이션 등 꽤 어려운 task들을 수행해내고 있습니다. 그러나 근본적으로, 이 2개의 용어는 통계적인 분류 문제에 대한 모델을 설명하는 것에서 정의됩니다. Classification 의 정의를, 위 그림에 맞게 다시 설명해봅시다. 각 데이터 $X$가 있고, 레이블된 클래스 값 $Y$가 존재합니다. Classification는 입력 데이터를 사전에 정의..