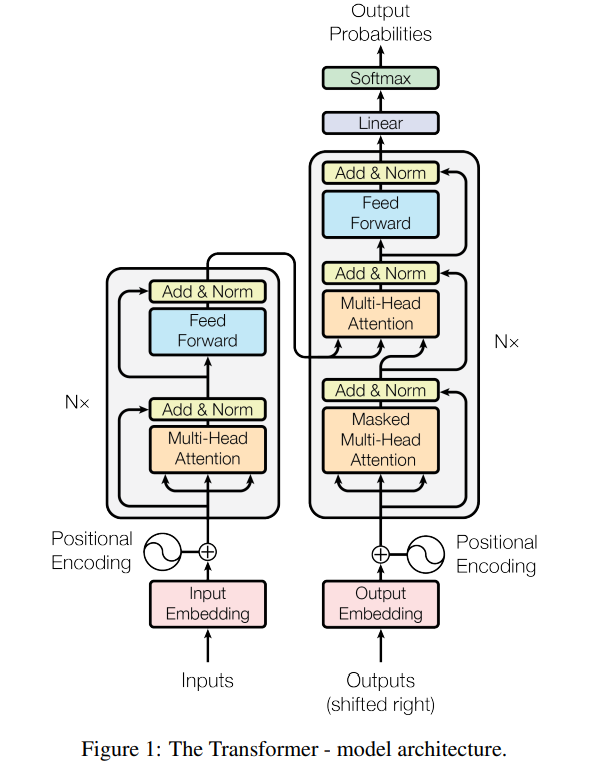

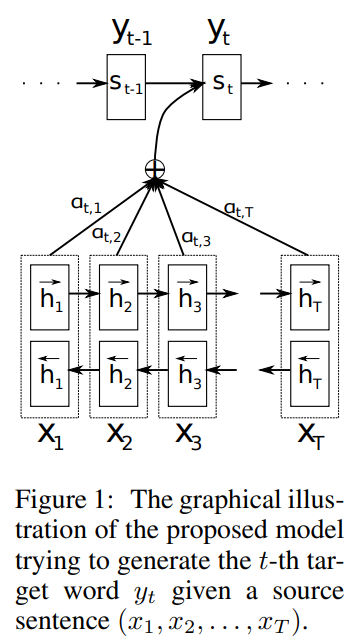

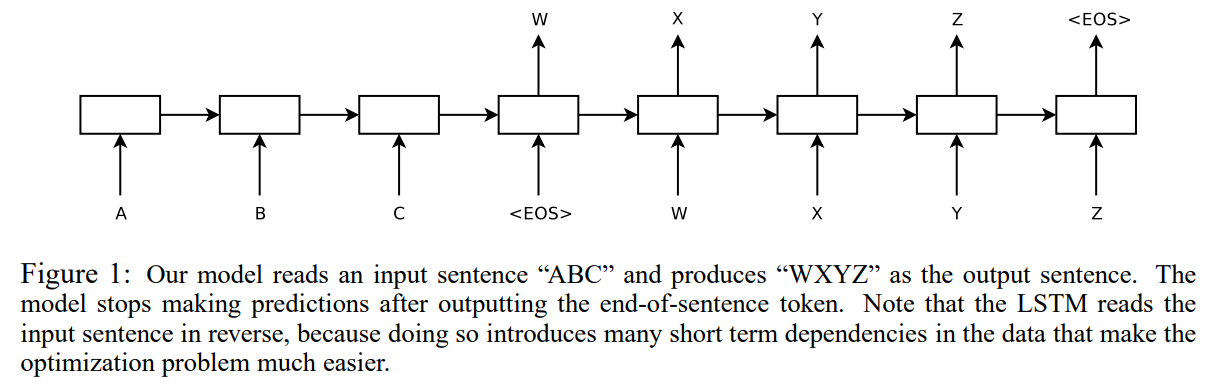

오늘 소개할 논문은 최근에도 자연어 처리와 비전 분야 모두에서 월등한 성능을 보이면서 발전하고 있는 Transformer 에 대한 논문입니다. 비전공자도 누구나 아는 ChatGPT 에서 GPT model 또한 Transformer 의 디코더 아키텍처를 활용한 모델입니다. Transformer 을 처음으로 제안한 논문이 바로 "Attention is All You Need" 으로 논문의 이름에서 알 수 있듯 트랜스포머 아키텍처는 Attention 메커니즘을 핵심 아이디어로 사용하고 있다는 것을 유추할 수 있습니다. 바로 이전의 논문 리뷰 순서가 Seq2Seq, Seq2Seq with Attention 논문이었습니다. Seq2Seq 는 기존의 통계적 기계번역이 아닌 신경망 기계번역, 그 중에서도 인코더-디코..